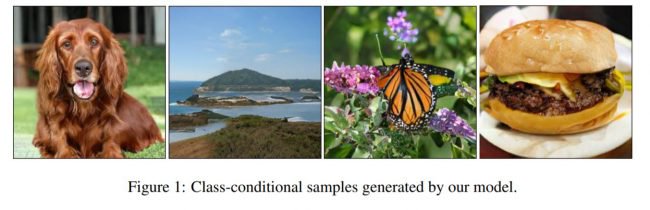

Британская компания DeepMind, в 2014 году ставшая частью Google, постоянно работает над совершенствованием искусственного интеллекта. В июне 2018 года ее сотрудники представили нейронную сеть, способную создавать трехмерные изображения на основе двумерных. В октябре разработчики пошли дальше — они создали нейросеть BigGAN для генерации изображений природы, животных и предметов, которые сложно отличить от настоящих фотографий.

Как и в других проектах по созданию искусственных изображений, данная технология основана на генеративно-состязательной нейросети. Напомним, что она состоит из двух частей: генератора и дискриминатора. Первая создает изображения, а вторая оценивает их схожесть с образцами идеального результата.

В этой работе мы хотели стереть грань между изображениями созданными ИИ и фотографиями из реального мира. Мы обнаружили, что для этого достаточно уже существующих методов генерации.

Чтобы научить BigGAN создавать фотографии бабочек, собак и еды, использовались разные наборы изображений. Сначала для обучения использовалась база ImageNet, а затем — более масштабный набор JFT-300M из 300 миллионов изображений, разделенных на 18 000 категорий.

Обучение BigGAN заняло 2 дня. Для этого потребовалось 128 тензорных процессоров Google, разработанных специально для машинного обучения.

В разработке нейросети также участвовали профессора из шотландского Университета Хериота-Уатта. Подробности о технологии расписаны в статье «Обучение

крупномасштабной генеративно-состязательной нейросети GAN синтезу естественного изображения высокой точности».

В сентябре исследователи из Университета Карнеги-Мелона при помощи генеративно-состязательных нейросетей создали систему для наложения мимики одних людей на лица других.

Как подобные нейросети могут быть использованы человечеством? Свои варианты пишите в комментариях или в нашем Telegram-чате.